Una estación de trabajo o workstation podría ser un equipo de sobremesa que sirva para todo menos para aquello para lo que está pensado. Un mal bicho que mueva bien cualquier entorno CAD, que renderice, que vectorice, que calcule, que maquete grandes formatos y que no se cuelgue, que pueda mantener abiertos una docena de programas, que no se caliente en exceso, pero que tampoco nos haga comer arroz blanco el resto del año.

Tras varios años sometiendo a 5 o 6 equipos de gama media-alta a innumerables horas sin parar de trabajar con programas y procesos bastante exigentes, hemos llegado a la conclusión de que invertir grandes cantidades de dinero -que no tenemos- en un equipazo no es casi nunca la mejor solución.

Una de las cosas que nos sucede a los estudios de arquitectura, diseño, construcción, etc. es que necesitamos «mucho de todo». Mejor dicho: «bastante de todo» (mucho no siempre es sinónimo de bueno). No nos caracteriza precisamente una especialización en tal o cual cosa, tocamos muchos palos a lo largo de un encargo y eso es algo que cuesta entender y aceptar a veces.

Esta forma de trabajar debe reflejarse en nuestra principal herramienta de trabajo. No necesitamos un componente enormemente especializado por lo que nos apañamos casi con cualquier cosa -lo cual es una gran ventaja- pero no podemos permitir que la estación de trabajo se quede corta en ningún campo, cosa que desembocaría en que un proceso se bloquee o una fase concreta se ralentice, poniendo así en peligro todo un encargo.

Índice de contenidos

Con este artículo no queremos hacer una de esas superguías definitivas de gurú digital, ni tan siquiera pontificar acerca de que ésta sea la única solución, receta o combinación que pueda existir. Tan sólo pretendemos ser generosos y contar nuestra experiencia, por si a alguien le sirve. Arrancamos.

CPU para modelado CAD 3D y BIM

Lo primero de todo es exponer que el motivo de este artículo es la compra de un nuevo equipo que acabamos de recibir. Se trata de una torre ATX que queremos que nos sirva como ordenador de apoyo o estación de trabajo de reserva. En la actualidad disponemos de tres unidades de sobremesa y otros tres portátiles, alguno de ellos con algunos añitos pero que funcionan muy bien y su rendimiento es francamente bueno.

Esta cuarta workstation tipo torre la queremos para utilizar en una serie de fases dentro de nuestro proceso de trabajo que a nuestros equipos actuales les cuesta un poco. Por ello, hemos partido desde un principio de un presupuesto cuyo límite hemos fijado en los 1.500€.

Algunos de los que nos habéis preguntado por estos temas recientemente nos diréis que con ese dinero poco se puede hacer. Y tendréis razón. Una tarjeta Quadro Pascal P4000 de 8Gb ya cuesta más de 1000€, y una Quadro RTX 4000 también de 8GB solo un poco menos de esa cifra. Ambas son tarjetas muy buenas pero no lo suficiente.

Procesadores de 10 núcleos como el i9 9820X o el i9 9900X rondan los 1.000€ y los de 16 o 18 núcleos llegan fácilmente a ese número y algunos modelos superan incluso nuestro presupuesto total. De los últimos procesadores de Intel de 10ª generación ya ni hablamos. ¿Por qué entonces ese límite caprichoso y tontorrón de los 1.500€ si no podemos ni soñar con lo último?

Esa cifra es una cantidad de dinero moderada. No es el presupuesto del equipo total pro de gamer forrado que no piensa en otra cosa, pero tampoco es el ordenador básico para instalar Openoffice, Chrome y Minecraft. Se trataría de una máquina no-pija que podríamos comprar con facilidad en la mayoría de las tiendas de informática online y físicas, con componentes estándar de marcas conocidas, que nos va a permitir trabajar con programas muy muy exigentes y que podemos adquirir con bastante menos de un mes de beneficios netos.

Programas de diseño con los que trabajar

Posiblemente aquí entremos en arenas movedizas pues no todos trabajamos con los mismos programas y complementos corriendo en nuestra estación de trabajo. Incluso aunque algunos de ellos sirvan para lo mismo y utilicen motores idénticos, el rendimiento y las exigencias nunca son exactamente iguales. Vamos a empezar haciendo un análisis de los requisitos y las demandas de algunos programas que utilizamos o conocemos.

Aunque la gran mayoría son herramientas conocidas, no conocemos muchos otros y este texto tampoco pretende ser una tesis doctoral. Si deseas aportar alguna información a esta reseña y a nuestros conocimientos, puedes escribir un comentario o enviarnos un email.

Sistema operativo, ofimática y bases de datos

Empecemos por lo básico, por lo que menos problemas nos va a causar. Un disco de 4GB de RAM, un procesador de hace 8 o 10 años y una placa base actualizada que no haya sufrido daños es más que suficiente para utilizar la mayoría de los programas habituales con el último Windows. Si lees esto desde el futuro, hoy estamos con Windows 10 y varias actualizaciones.

Un office libre, navegadores cargados de complementos, visualizador de fotos, el VLC, codecs, un antivirus, un antimalware, un gestor de copias programadas, algo para copiar CDs, Spotify, un programa de videochat, Pdf Reader, Outlook o Thunderbird, un par de limpiadores, cortafuegos y los drivers de todo el hardware y periféricos.

No se necesitan requisitos especiales para el usuario básico. Con un presupuesto de 300-350€ podemos tener un equipo estupendo para estos menesteres con un procesador de 2 núcleos, 4GB de RAM con una velocidad media, gráfica integrada en una placa AMD modesta y un disco Seagate de 1TB. Nos quedaría incluso algo de presupuesto para añadir un disco SSD de 120GB y un disipador por aire de marcas baratas.

A esta muy digna configuración no podríamos llamarle estación de trabajo… aunque lo sea. Sin embargo, le podemos añadir alguna mejora en el rendimiento del sistema operativo como cambiar las opciones de energía (mejor rendimiento a costa de más consumo), recortar los programas y los servicios de arranque, desactivar la indexación y sobre todo quitar las chorradas.

Podemos añadir la lista de programas anterior algunos otros más específicos como Microsoft Project, Primavera, o sus versiones libres Planner, OpenProject o «projects online» que los hay, y buenos. También los Menfis, Arquímedes, Arksoft, Gropit o sus hermanos diabólicos Presto y TCQ. Ninguno de ellos nos va a saturar la memoria ni el procesador durante largo tiempo.

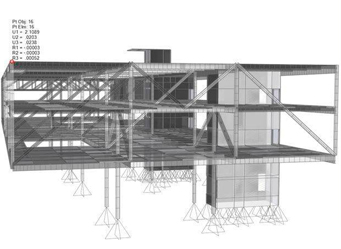

Cálculo de estructuras

Programas para el cálculo hay de muchísimos tipos, pero quizás el estructural sea uno de los más exigentes. Dentro del campo de la construcción el cálculo de estructuras y geotecnia son los que seguramente pongan nuestra pseudo estación de trabajo de 300€ bien caliente.

Conocemos dos tipos de programas computacionales: el primero es aquel con una interfaz intuitiva, un montón de parámetros útiles, una interesante facilidad de manejo para el usuario medio y una gran opacidad una vez que se sobrepasan ciertos límites. El gran adalid de este tipo de programas es Cypecad para cuyo aprendizaje se venden por ahí cursos de 20 horas, pero hay otros también -no sin interés- como Robot de Autodesk o Ansys.

Los modelos de estos programas deben ser muy atractivos para seducir al usuario, por lo que la dependencia no solamente será de procesador, sino también de tarjeta gráfica o GPU. Si nuestra CPU se encarga tanto del trabajo computacional como de la interfaz, perderemos mucha velocidad y en el momento en que la estructura, las combinaciones de carga, las envolventes y el segundo orden se carguen bien, tendremos que esperar un buen rato los resultados.

Sin embargo, otros programas como SAP2000 no tienen tanto tirón gráfico. Su interfaz no es mala -al contrario- pero es mucho más ligera y todo el trabajo se centra en el cálculo matemático, el cual es además completamente configurable, con infinidad de parámetros y posibilidades. Como es lógico, este tipo de programas no se aprenden con un curso online.

Lo ideal sería que nuestra estación de trabajo diese apoyo al procesador con una tarjeta específica para computación de última generación, por ejemplo, la Tesla P100 de la gama Pascal de Nvidia, con 12 o incluso 16Gb de memoria. Aunque podamos insertar uno de estos tarjetones en una ranura PCIx3 su tecnología interna está pensada para procesado de imágenes científicas, inteligencia, defensa, medicina, biotecnología, astrofísica o meteorología. Cuestan de 6.000€ para arriba, por lo que usarlas para cualquiera de los programas mencionados no solamente es tirar el dinero, sino que posiblemente no lleguemos a hacerlas funcionar más rápido que un buen procesador, aunque la tarjeta cuente con un número mucho mayor de núcleos (cientos o miles).

Ni siquiera la opción de gama inferior con tecnología RTX como la Titán-X o las Georce de la serie 30 con un precio en el entorno de los 2.000€ son una opción.

Para un usuario medio cuyo trabajo no es meramente computacional y no depende exclusivamente de un bicho de estos, la mejor opción es un procesador rápido de varios núcleos: 6 u 8 que podría estar entre los 300 y los 500€. Si podemos optar a 10 o 16 núcleos duplicaremos o triplicaremos el precio, pero iremos más rápido. En sus especificaciones técnicas SAP2000 dice que aprovecha un mayor número de hilos en la opción multinúcleo, pero tampoco concreta números, diferencias o equivalencias, ni hay manera de comprobarlo con certeza.

Fotogrametría

Seguimos en el mismo problema de computación geométrica: análisis de puntos en cientos o miles de imágenes, casamiento, orientación, generación de modelos, nubes densas de puntos, ortofotografías, mapas de profundidad, inteligencia artificial, etc. No podemos sino hacer referencia a otro artículo acerca del manejo del Metashape para la documentación 3D del Patrimonio Histórico, en el cual describimos la línea básica y más habitual de procesos.

En este caso tenemos una importante ventaja con respecto al cálculo puro y duro, y es que programas como Photomodeler, Pix4D, ReCap o el que mejor conocemos: Metashape -el antiguo Photoscan-, todos ellos tienen opciones más o menos potentes de aprovechar la potencia de la GPU.

Ignoramos si activar esta función es exclusivamente una opción de tipo manual, o existe un uso combinado de los núcleos del procesador y los de la tarjeta gráfica que el programa encuentre. Si es una Voodoo 3 o una RTX 3090, nuestro programa de fotogrametría las va a poner a trabajar a tope hasta que termine de montar la nube densa o la malla, que son dos de los procesos más largos.

Por eso, un equipo en el que vayamos a usar un programa de procesado de imágenes como los anteriores no debería dejar todo este trabajo de horas y horas al procesador: debe incorporar casi obligatoriamente una tarjeta gráfica. Puede que la opción GTX -la tarjeta gamer no supercara de toda la vida- sea la mejor en cuanto a calidad/precio, buscando un mayor número de núcleos y también más memoria, dos características que afortunadamente suelen ir de la mano.

Las tarjetas tipo Quadro con chips Pascal, RTX o Quadro RTX con tecnología Turing permitirán procesados en paralelo, pero el coste es muy alto y posiblemente el cálculo de estos programas sea 100% lineal con lo que nuevamente estaríamos desaprovechando nuestros recursos.

Photoshop y programas de edición de imágenes

Podemos meter en un mismo saco a un puñado de programas como son los Photoshop, Illustrator, Indesign, Lightroom de Adobe, el Corel Draw o el GIMP, así como algunas aplicaciones de Canon o Nikon: Camera Raw, Capture One y algún otro. Se usan fundamentalmente para el procesado de fotos ya generadas, el montaje, el retoque y el revelado.

Alguno de ellos también añade al trabajo con imágenes raster funciones vectoriales para maquetación y diseño gráfico, infografías, impresión, edición etc. La principal característica de todos ellos es que, en la mayoría de los casos, necesitan abrir una enorme cantidad de datos a la vez. Las imágenes RAW tomadas con cámaras profesionales o las maquetaciones de gran formato con una gran cantidad de imágenes en ellas ocupan varios gigabytes.

No podemos decir qué demandará cada uno de estos programas a nuestra estación de trabajo en un momento dado, todo dependerá del proyecto en el que trabajemos. El revelado RAW o la automatización de procesos utilizará en gran medida el trabajo de procesador. Un procesador rápido, pero sobre todo uno multinúcleo será de gran valor.

Sin embargo, para trabajar con grandes conjuntos de elementos (girar o mover grupos completos, operar con grandes selecciones o mover a la vez decenas o cientos de capas) el servicio de la GPU es de lo más importante, aunque demasiados núcleos tampoco serán la mejor solución. Debemos tener en cuenta que los procesadores de 10, 16 o más núcleos son absolutamente prohibitivos pero, además, tener siempre presente la ley decreciente de rendimiento: un proceso no se ejecuta 4 veces más rápido en un i9 de 16 núcleos que en un i5 de 4 núcleos con velocidades similares.

Como son bastantes los programas mencionados, no vamos a entrar a hablar de cada uno de ellos en profundidad. Diremos solamente que Adobe y otras marcas nos dan la posibilidad de ajustar el trabajo del procesador gráfico para acelerar el rendimiento, el cálculo interno de cada programa, la manita del OpenCL o incluso el reparto de la carga de trabajo entre la CPU y la GPU.

Concretamente Adobe Photoshop ya no usa los núcleos de tipo CUDA para procesar, por lo que da opción a usar un GPU cualquiera mientras se tengan los controladores OpenGL y OpenCL actualizados, mejor siempre los del fabricante que los estándares de Nvidia. Nvidia: fuck you!, -dijo L. Torwald.

Las acciones que más beneficiadas se van a ver por el uso de una tarjeta gráfica potente -siempre pensando en 2 gigabytes de memoria como mínimo- con OpenGL y OpenCL son: el zoom con arrastre, las mesas de trabajo, la percepción de la calidad de una imagen al ser escalada o deformada, los filtros basados en desenfocar, el enfoque suavizado o la deformación con persepectiva; del resto no se especifica mucho. Sin embargo, para otros programas de la suite de Adobe como Illustrator o Indesign los nucelos CUDA de la GPU serán fundamentales, así como para algunas funciones y plugins del propio Photoshop el cual, a fin de cuentas, es el programa más importante.

Un procesador multinúcleo de gama media y una tarjeta gráfica con CUDA de 2GB o más en el interior de nuestra estación de trabajo serán buenos aliados. Pero por encima de ellos siempre estará la memoria RAM si hablamos del trabajo con imágenes y productos gráficos. En este punto no solamente nos deberíamos olvidar de sistemas operativos de 32 bits que no aprovechan más de 2GB de RAM, sino aquellos equipos con 4GB o más. Para trabajos profesionales podríamos tomar la siguiente referencia:

Archivo de 100MB: RAM mínima 6.689 Mb – RAM recomendada: 8Gb/16GB

Archivo de 250MB: RAM mínima 10.970 Mb – RAM recomendada: 16GB

Archivo de 500MB: RAM mínima 17.225 Mb – RAM recomendada: 32GB

Archivo de 750MB: RAM mínima 24.624 Mb – RAM recomendada: 32GB/64GB

Archivo de 1024MB: RAM mínima 31.471 Mb – RAM recomendada: 64GB

Archivo de 2048MB: directamente RAM recomendada: 128Gb

Esto quiere decir que la necesidad de memoria RAM crece exponencialmente en relación a dos factores: el primero es el número de imágenes, capas, máscaras, selecciones, etc. que tengamos abiertas o en funcionamiento de manera simultánea y el segundo el tamaño de los archivos abiertos. Si nuestra memoria es insuficiente, ésta se llenará cerca del 100%, el programa directamente se ralentizará hasta el punto de detenerse.

Para que esto no suceda, Photoshop se puede configurar para que use un porcentaje de la memoria RAM, a partir del cual empezará a usar espacio del disco duro a modo de «disco virtual». Por supuesto la lectura de datos de nuestro HHD es muchísimo más lenta que de las tarjetas de memoria y esto hace que este recurso es un complemento, pero en ningún caso una solución a la escasez de RAM.

Hablamos de que la tasa de lectura de un disco SATA normal es de 80-100MB/s, la de un sólido SSD tradicional es de unos 500MB/s mientras que la velocidad de una memoria NVMe podría alcanzar más de 3000MB/s. Lo ideal sería que no agotásemos nunca la memoria RAM pero, en el caso de hacerlo, nuestra segunda mejor opción será tener configurado como disco duro virtual una memoria M.2 en vez de nuestro disco de arranque o en el que tengamos instalado el sistema operativo.

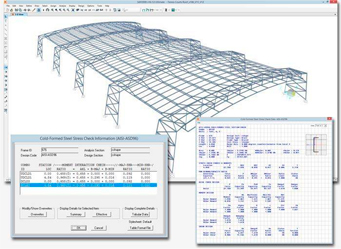

Autocad 2D y 3D

Entre BricsCAD, LibreCAD, FreeCAD, Rhino o Microstation nos quedaremos por ahora con Autocad que, por desgracia, es la referencia mundial. Otros programas no pueden dejar de ser mencionados: Allplan, Archicad, Catia, Tekla o Solidworks. Cuando decimos CAD nos estamos refiriendo al dibujo, no al modelado. Esa es una fina línea la cual, pese a todo lo que estamos viendo hoy en día con asombro y admiración, no queremos dejar de tener en cuenta.

Teóricamente las tarjetas gráficas ideales para mover dibujos y modelos lineales (3D, sólidos, mallas, etc.) deberían ser las Quadro Pascal o las actuales Quadro RTX. Si aceptamos que las del segundo grupo son prohibitivas por ser más recientes y nos quedamos con la gama más clásica de Pascal, necesitaríamos algo más de los 2Gb que nos dan los modelos más básicos como la P400 o la P620.

Con una Quadro P2200 de 5Gb del tipo GDDR5 tendríamos una tarjeta en el límite de nuestro presupuesto para GPU, posiblemente más de lo recomendable. Sin embargo, nuestra estación de trabajo moverá sin problemas cualquier modelo con todos los millones de triángulos que queramos. Tendríamos que invertir entre 500 y 600€ solamente en una tarjeta gráfica profesional cuyos equivalentes en tarjetas gamers nos proporcionan casi el doble de memoria dedicada.

¿Qué quiere decir esto? Que con lo que nos cuesta una Quadro P2000 o P2200 nos podríamos hacer con una Geforce con tecnología RTX de la serie 20, como la RTX 2070 Supergaming X con 8Gb GDDR6 o, si nos volvemos un poco locos buscando, una Geforce RTX 3070 básica.

Nuestra experiencia es que ambos tipos de tarjeta (Quadro vs Geforce) funcionan bien con los modelos que usamos habitualmente: edificios, ciudades, detalles constructivos, superficies curvas, modelado y creación de terreno, modelado de caras, etc. Sin embargo, con las Quadro los errores en pantalla suelen ser más comunes y desquiciantes. A igual rendimiento, la clase Geforce se comporta mejor, produciendo menos aberrancias y proporcionando más fluidez y suavidad en pantalla.

BIM

Más de lo mismo. En la actualidad mover modelos en Revit, Allplan, Archicad o la rareza Aecosim no difiere de gestionar modelos CAD 3D grandes y cargados. El suplemento de información paramétrica a la información gráfica espacial es irrelevante en cuanto a demanda del equipo que utilicemos.

Procesadores ultrarrápidos de varios núcleos y muchos hilos no nos van a dar ninguna ventaja a la hora de trabajar en estos entornos, salvo en momentos puntuales a la hora de abrir archivos grandes, guardar o imprimir varios archivos de manera simultánea, hacer una operación masiva muy grande como sombrear, seccionar, modificar nubes densas o convertir e importar otros formatos.

Tanto para CAD como para BIM, los dos elementos más importantes de nuestra estación de trabajo por este orden serán la tarjeta gráfica y la memoria RAM. Aunque de esta última no nos debemos preocupar en exceso puesto que la mayoría de las cargas de memoria de estos proyectos son vectoriales: a diferencia de las imágenes o los vídeos, los modelos 3D son notablemente más ligeros. Al menos en cuanto a cantidad y tamaño de información y archivo.

Renderizado con 3dMax, Sketchup o Blender

Aunque algunos de los programas de CAD y modelado 3D que acabamos de mencionar tienen capacidad de sombreado y renderizado, siempre preferiremos acudir a un software especializado para modelar y renderizar imágenes de objetos y ambientes.

No entramos en diferenciar programas y motores ni tampoco las diferentes combinaciones y compatibilidades entre ellos; solamente distinguiremos la división del proceso en 2 partes: modelado y procesado.

Para la primera de ellas ya tenemos el problema analizado. Estos softwares están más orientados al modelado directo de objetos, formas y superficies que al dibujo, el proyecto arquitectónico o el diseño de ingeniería. Sin embargo, su objetivo es el mismo: trabajar con modelos simplificados o vectoriales que aunque nos hacen creer que tienen menos polígonos de lo que deberían pero que en realidad representan o son formas trabajadas y complejas.

Las dos imágenes anteriores son de dos ambientes muy diferentes: el primero con iluminación artificial interior y el otro con iluminación exclusivamente natural del sol, pero también realizados con programas y motores de renderizado distintos. La cocina está modelada con Sketchup de Trimble y su plugin Vray. El aula está modelada en Blender y renderizada con Cycles. En un caso el trabajo se centra en emular las características de los materiales de la cocina y las prestaciones de las luminarias mientras que, en el otro, el objetivo era el ensuciar el dibujo con efectos como el polvo o la roña.

El proceso de modelado de ambas escenas es muy similar y acertaremos si decimos que con un equipo mediano se modela esto en un pispás: procesador i5 dual core, 8 Gb de RAM y una tarjeta Geforce GT640 bastante vieja y usada de tan solo 1Gb dedicado.

Otra cosa es cuando empezamos a usar shading, colores, transparencias, brillos, metales, reflexiones, refracciones, rugosidades, decenas de materiales, imperfecciones, etc. miles de efectos, plugins y nodos. Cuanta más información tengamos en el modelo, más CPU o procesador necesitaremos para convertir, modificar y combinar, pero realmente para mover los objetos o las escenas nuestra exigencia primaria seguirá siendo la velocidad de la tarjeta gráfica o GPU.

Como ejemplo de lo anterior podríamos trabajar con una escena como la anterior y tratar de moverla en tiempo real. La cantidad de ruido artístico, de hojitas, de brillos, de rugosidades, las formas orgánicas, las superficies onduladas del terreno, el efecto ondulatorio del viento sobre la superficie del agua o las impurezas de los paramentos hacen que un modelo muy sencillo de generar en un software vectorial como Autocad, sea complicadísimo de mover en 3DS Max.

Sin embargo, todo lo anterior cambia cuando procesamos una escena mediante rayos para crear una imagen estática que recoja toda la calidad de nuestro trabajo. En este caso será el procesador el que ponga a trabajar a todos sus hilos en un proceso que nunca es corto cuando se trata de escenas de arquitectura o construcción.

El ray tracing de cualquiera de las escenas anteriores supera las 7 horas de trabajo ininterrumpido con un Intel Core i7 4790K de 4 núcleos y 4,40 GHz, las 4 horas con un i7 8700K de 6 núcleos y 3,70 GHz, y algo más de 2 horas con un i7 10700K de 8 núcleos y 5,10 Ghz. Hacemos la observación de que todos estos procesadores son de la serie K y los tenemos overclockeados para obtener la máxima velocidad. En el resto de actividades no sería necesario, pero precisamente en el renderizado estático con motores de gran calidad como el Vray o el Cycles, es fundamental.

Renderizado CPU vs GPU

O lo que es lo mismo, procesar la imagen final exclusivamente con el procesador de la estación de trabajo, hacerlo con la tarjeta gráfica, o bien utilizar ambas mientras se complementan entre sí.

¿De qué depende o qué opción es mejor? Sin duda la proporción perfecta es que trabaje más aquel componente en que más hemos invertido. Si hemos adquirido un procesador multinúcleo overclockeado y muy rápido, que trabaje éste. Si, por el contrario, hemos comprado una tarjeta gráfica excelente con mucha memoria de video dedicada y varios miles de nucleos, aprovechémosla.

Como veremos a continuación, lo ideal es equilibrar ambos componentes entre sí y también con el resto de la estación de trabajo, por lo que con esta opción, lo ideal sería su trabajo conjunto.

Si usamos 3DS Max con su motorcillo Arnold, éste permite elegir uno u otro modo, pero no los dos. Si optamos por Vray, éste motor nos permite combinar ambos procesados pero sólo teóricamente: no lo hará como querríamos sino que algunos subprocesos como el trazador iRay lo hará la GPU y otros como el renderizador Corona lo hará la CPU. Veremos todos los hilos del procesador trabajando al 100% y un rato después los ventiladores de la tarjeta gráfica bufando y haciendo vibrar toda la estación de trabajo, pero no una verdadera colaboración.

Con Sketchup y Vray pasa otro tanto. En teoría podemos escoger entre CPU, CUDA o RTX y también una interacción entre ambos. Incluso nos deja escoger entre 3 grados de colaboraciones: alta, media y baja. Pero en la realidad funcionan como si fuese una carrera de relevos, lo cual no deja de ser interesante. En media podemos hasta seguir trabajando al no tener los núcleos del procesador saturados.

En el caso de Blender la cosa cambia. Aquí sí que hemos visto una colaboración estrecha entre ambos motores, tanto en el render de trabajo Eevee como en Cycles. Especialmente con Eevee, con el cual podemos seguir modelando y usando los overlays sin problema. Ambos, CPU y GPU trabajan a la vez en diferentes subprocesos del modelado y el renderizado en tiempo real, lo cual es fantástico, siempre y cuando no abusemos ni superemos las capacidades límite de nuestra estación de trabajo.

Necesidades de placa, CPU, RAM y almacenamiento a tener en cuenta

Bien, ya estamos entrando en calor. Con las anteriores necesidades de RAM, CPU y GPU en función de nuestro trabajo ya estamos en disposición de terminar de conformar nuestra estación de trabajo. Es el momento de escoger una placa base en la que montar todo lo anterior.

Lo que hemos considerado más interesante es en disponer de ranuras para ampliar la RAM en el futuro, es decir, no comprar un número de tarjetas de memoria que nos llenen toda la placa. Si nuestra placa dispone de 4 ranuras, una opción sería repartir la RAM que decidamos adquirir en 2 ranuras y dejar las otras 2 para futuras ampliaciones.

El otro aspecto a tener en cuenta es que la placa sea compatible con el procesador, lo cual se consigue haciendo que coincida el tipo de socket. En nuestro caso nos hemos decantado por el ya antiguo pero fiable LGA 1151 de Intel.

De los discos tampoco hay que hablar mucho. Un disco sólido SSD para el arranque y el sistema, y otro igual de rápido para la caché es una opción ganadora. Esto solamente servirá si utilizamos archivos muy grandes que nos vayan a saturar la RAM. Photoshop, por ejemplo, es un programa que se puede configurar para que aproveche un disco de memoria virtual en apoyo a memoria de la estación de trabajo. En caso de no tener ese segundo SSD, la caché utilizará la memoria de C: por lo que recomendamos no tenerlo excesivamente lleno y seleccionar los programas a instalar.

Solamente nos queda escoger la placa base y nuestra elección pasa por ASUS. No hay una razón de peso como no la hay en que hasta ahora hayamos hablado de Intel y no de AMD, de marcas como MSI o PNY y no de otras como Gigabyte o Aorus. Siempre hemos usado ASUS y nos ha funcionado así que seguiremos confiando en este fabricante.

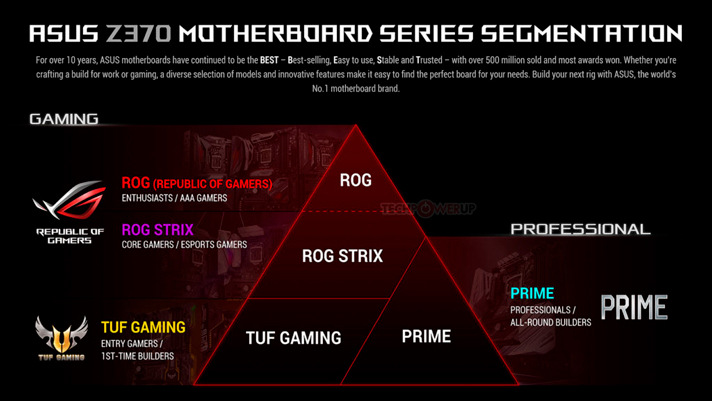

El siguiente esquema es muy intuitivo para ver la gama de placas base de ASUS en función de lo que queramos de ella.

A la izquierda tenemos las placas para juegos, con las más potentes en cuanto a rendimiento, potencia y capacidad de aprovechar la GPU. Gamas Republic of Gamers, ROG Strix y The Ultimate Force para proporcionar modelos y precios para todos los públicos.

A la derecha nuestra elección: la gama PRIME más estable que combina equilibrio y estabilidad sin tanta agresividad ni predisposición a llevar los últimos modelos de socket de CPU, de RAM o de conexiones con los periféricos o con el exterior. Una placa PRIME va a ser más modesta y económica, pero nos va a proporcionar todo lo que necesitamos.

Estación de trabajo por componentes

En la siguiente tabla hemos recopilado los principales componentes de la workstation que acabamos de adquirir:

Torre: ATX invertido Carbide Series™ Clear 600C

Placa base: ASUS Prime Z390-A

CPU: Intel Core™ i7 10700K 3.80/5.10GHz de 10ª Generación

Archivo de 250MB: RAM mínima 10.970 Mb – RAM recomendada: 16GB

GPU: PNY Quadro Pascal P2200 5Gb GDDR5

Disco SSD Samsung 970 EVO PLUS 500Gb

Disco HDD 3.5″ 2TB WD SATA3 Black (un clásico)

Memoria RAM: Kingston HyperX FURY DDR4 32GB 3200MHx CL18 Black

Refrigeración líquida: Cooler Master Masterliquid 240

Alimentación: SEASONIC Prime Ultra 850W Gold

En el establecimiento en el que hemos comprado siempre nuestros equipos, esta modesta pero estupenda estación de trabajo tendría un precio de unos 1.520€ a los cuales no habría que añadir nada más siempre y cuando nos animemos a montarlo nosotros mismos. Montar un equipo por piezas es una tarea fascinante y muchísimo más sencilla de lo que parece, pero se necesita algo de experiencia.

No incluimos por tanto un kit de herramientas de cierta precisión, la pasta térmica, tornillos, bridas, portacables, tacos, cables SATA extra, base con ruedas ni lector de DVD. Todo eso ya lo teníamos así que nos hemos puesto manos a la obra, añadiendo a todo lo anterior dos unidades de disco HDD de 3,5″ más y un adaptador de unidad 3,5″ a 5,25″ que cuesta nada pero que sí es un poco engorrosa de montar en la Carbide 600C.

Como conclusión: estos 1.500€ largos están más que bien invertidos. Esta estación de trabajo es para quienes nos cuesta ganar el jornal. No es el equipo del rendero sin problemas de presupuesto, pero tampoco es un PC de sobremesa. No nos va a mover con soltura una ciudad modelada en 3D Max pero sí va a servirnos para modelar en 3D con comodidad. Nos va a calcular estructuras muy bien y va a permitirnos trabajar con imágenes grandes y proyectos gráficos de ilustración y video importantes.

En el momento en el que escribimos este artículo hemos importado y movido un modelo enorme .3ds de todo el Castillo de Peñafiel con su cerro y el Museo del Vino, hemos abierto y manipulado archivos .psb de casi 2Gb de peso (que se dice pronto), hemos jugado a The Witcher 3 con sus 2 ampliaciones con el rendimiento gráfico y hemos movido bastante bien un modelo 3D de CAD de 150Mb que con nuestro anterior equipo siempre fue un dolor de cabeza.

Asimismo hemos procesado una imagen .tiff con VRay de gran tamaño de 190Mb de peso y hemos procesado un video de 15 minutos de duración con Premiere pero con un master de mucha calidad. Esto nos ha llevado ya del orden de minutos / horas. También en este orden de tiempos hemos obtenido nubes densas de puntos en Metashape con gran facilidad y hemos generado mallas de 12 millones de triángulos.

Sin embargo, una cosa que no hemos podido hacer es generar una malla 3D de 25-30 millones de triángulos porque además de la lentitud del proceso de entre 3 y 4 horas, los 32Gb de RAM no son suficientes, dudando que incluso que con 64Gb (el doble) se pudiera conseguir.

Estamos de acuerdo ¿pa qué una tarjeta para pijos cuando las de juegos no tienen rival? Yo compré justo hace un año una GTX 2080Ti y es la polla. La uso para los Dark Souls III y Demon Souls, el Baldur’s Gate 3, Last of Us 2, el Shadow of the tomb rider y los últimos Final Fantasy y la verdad es que funciona con los gráficos a tope de lujo. De hecho no solamente mueve los juegos genial sino que no se nota ralentización mientras grabo para streaming.

Por otro lado Blender, Maya o Zbrush que son los programas de diseño 3D que uso imagínate cómo los gestiona. En fin una pasada. Buena reseña +1

Enhorabuena por la web. ¿Algún comentario sobre las nuevas tarjetas RTX con touring? Creo que para estos trabajos que comentáis son el presente y el futuro.

Este artículo me ha ayudado bastante, voy pasar de un pc antiguo a una workstation del precio que comentáis y estaba un poco perdido. Gracias